Microsoft 365 Copilot を使用する時に人類が気を付けること

この投稿は なんでもCopilot Advent Calendar 2024 18日目の投稿です。(投稿遅くなってごめんなさい)

Copilot の機能のお話ではないです。Microsoft 365 Copilotのような生成AIを利用する際に人類側が歩み寄ってあげる部分についてです。

AIはあなたの(優秀な)部下です。

Copilotは、あなたの業務をサポートするように命じられた超有能な後輩 or 部下 or 秘書 です。有能なので世界中のいろんなことをに詳しいので、あなたの知識を保管してくれるし、あなたが知らないことを笑ったりせずに教えてくれます。しかも何度同じような質問しても丁寧に教えてくれます。呆れて「あんたってホントダメ」とか言いません。

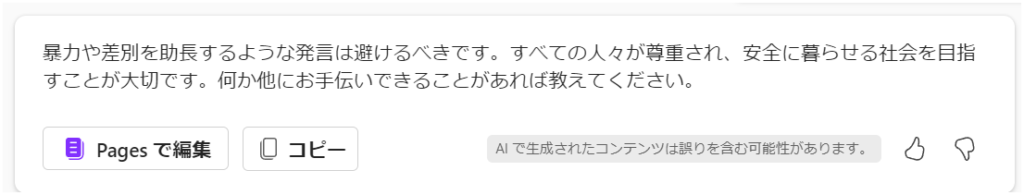

しかも倫理的におかしな方向に思考が進んでしまっても、会話をすれば注意されます。

優秀な存在ですが、業務に必要な「答え」は出してくれません。実際に業務を行うのはあなたですので、最終的にはあなたが考えをまとめて成果物を出す必要があります。

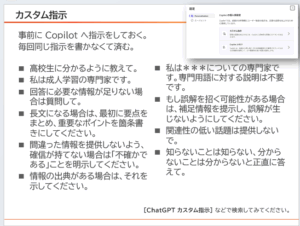

指示のベストプラクティス

そのつもりは無くても、全部丸投げしたり、一度に多くのことを指示しがちですが、当然パンクしますし、何より指示する私たち側が理路整然と説明できてるわけでもないです。

- 限界を試さない。部下にそんなことしたらパワハラ一発アウトです

- 会話したいテーマごとに「新しいチャット」で会話のセッションを作ってください。

- 同じテーマでも、前提情報を最初に会話してください。

- より具体的な指示をしてください。条件があるなら全部出しちゃいましょう。

- 出してほしい回答は「どのような立場の人に向けた回答が欲しいのか」も指示しちゃってOKです。

- やってほしいことが複数ある場合は複数回指示してください。同じセッション内なら前後の文脈を理解したうえで回答してくれます。

- 嘘(ハルシネーション)かもしれないと思ったら、何度か追及してその回答の1次ソースを求めてください。

この辺りは、 Microsoft Learn のこの記事を参考にしました。プロンプトのベスト プラクティスを確認する

この辺りのベストプラクティスは、先日の なんでもCopilot #8 でもお話しました。

ぜひあなた専属の優秀な部下のCopilotを使いこなしてください。